روباتها به یکدیگر مهارتهای جدید را یاد میدهند

فرض کنید در یک زمینه خاص فاقد مهارتهای مناسب هستید و حالا میخواهید در آن کسب مهارت کنید. چه کارهایی انجام میدهید تا به بهترین سطح ممکن برسید؟ کلاس میروید؛ دورههای خاص را میگذارنید یا شروع به تمرین میکنید؟ حالا در نظر بگیرید که بتوانید وارد مغز فرد دیگری بشوید و بهطور مستقیم از دانش؛ تجربیات و مهارتهای او استفاده کنید. این اتفاقی است که بهزودی برای روباتها خواهد افتاد.

شاید برای انسانها رسیدن به این نقطه در حد فیلمهای علمی تخیلی باشد اما این مسئله برای روباتیکهایی که به سیستم هوش مصنوعی مجهز هستند بهزودی ممکن میشود. اگر روباتها بتوانند تجربیاتشان را با یکدیگر به اشتراک بگذارند در مدت زمانی که برای آموزش آنها نیاز است؛ صرفهجوبی میشود.

همانطور که میدانید استفاده از سیستمهای هوش مصنوعی یا AI از جمله شاخههایی است که گوگل در چند وقت اخیر سرمایهگذاری عظیمی روی آن کرده و برنامههای بزرگی در سر دارد. مورد فوق نیز از جمله پروژههایی است که این غول موتور جستجوی دنیا دنبال میکند. در همین راستا؛ آنها بهتازگی این مسئله را با بازوی روباتی که قادر به گرفتن اجسام است به معرض نمایش گذاشتند.

شش سال پیش بود که رئیس بخش روباتیک گوگل بهنام «جیمز کافنر» برای این نوع مهارت یک کلمه جدید ابداع کرد: روباتهای کلاود (Cloud Robobtics). این امر به معنای تأثیر پردازش و سنسورهای پخشی از طریق دیتاسنترها و شبکههای سریعتر است. کافنر در حال حاضر CTO مؤسسه تحقیقات تویوتا است و تمرکز خود را بر روی روباتهای کلاود گذاشته تا بتواند رویای روباتهای کمکرسان در داخل خانه را به واقعیت تبدیل کند.

در همین راستا تیمهای Google Research؛ آزمایشگاه هوش مصنوعی انگلستان؛ DeepMind و گوگل ایکس در حال کار بر روی این پروژه هستند تا سرعت بهدست آوردن مهارتهای مورد نیاز برای اهداف عمومی را بیشتر کنند. در چند ویدئوی تبلیغاتی که بهتازگی توسط گوگل منتشر شده روباتهایی دیده میشوند که برای یادگیری سریع در زمینه نحوه فشار دادن اجسام به سمت جلو و باز کردن در از تجربیات یکدیگر استفاده میکنند.

محققان برای رسیدن به مولتی-روباتها از سه شیوه استفاده میکنند که یکی از آنها تقویت یادگیری و آموزش یا روش آزمون و خطا؛ در کنار شبکههای عصبی عمیق است. این دقیقا همان روشی است که DeepMind بهکار گرفت تا سیستم AI خود را به شکلی تعلیم دهد تا به درجه استادی در زمینه بازیهای ویدئویی آتاری و همچنین بازی چینی Go برسد.

هر روبات برای خودش یک کپی از شبکه عصبی را دارد که به وی کمک میکند تا بهینهترین گزینهها و کارها را برای باز کردن در انجام دهد. بههمین منظور؛ گوگل با اضافه کردن تداخل خیلی سریعتر؛ دیتا میسازد. در کنار آن؛ یک سرور مرکزی همه حرکات؛ رفتار و نتایج نهایی روبات را ضبط میکند تا با استفاده از آنها یک شبکه عصبی بهتری ساخته شود و در نتیجه به روباتها در بهتر کردن اعمالی که انجام میدهند؛ کمک میکند.

آنطور که گوگل در ویدئوهای منتشره نشان میدهد؛ روباتها بعد از نزدیک به ۲۰ دقیقه یاد گرفتند که با دست و پا زدن بالاخره در را باز کنند؛ در حالیکه بعد از گذشت سه ساعت؛ روباتها موفق شدند تا بهراحتی دستگیره در را بگیرند؛ بچرخانند و باز کنند.

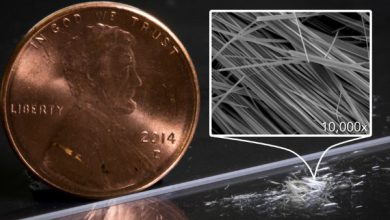

روش دیگری که آنها دنبال میکنند به روباتها کمک میکند تا با دنبال کردن یک سری دستورات و فرمانها اشیاء را در اطراف خانه جابهجا کنند. گوگل به روباتهایش آموزش میدهد تا با ساخت مدلهای ذهنی یاد بگیرند که چگونه در پاسخ به مجموعهای از حرکات مشخص اشیاء را تکان دهند. این آموزش از طریق افزایش تجربیات آنها حاصل میشود.

در این روش؛ روباتها تجارب خود در خصوص جابهجا کردن اجسام مختلف در دور یک میز را با یکدیگر به اشتراک میگذارند و بهکمک آن قادر هستند تا پیشبینی کنند در برابر انجام یکسری از حرکات ویژه چه اتفاقی ممکن است رخ دهد.

و در آخر؛ محققان در حال تحقیق بر روی روشها و راههایی هستند که روباتها از انسانها یاد بگیرند. این محققان روباتها را به سمت درها راهنمایی کردند و به آنها نشان دادند که چگونه باید در را باز کنند. این حرکات بهصورت کدهایی در درون شبکه عصبی عمیق گنجانده شدند که تصاویر دوربین را به حرکات روبات تبدیل میکند.

در اینجا نیز؛ روباتها به کمک انسانها؛ تجارب خود در خصوص تلاش برای باز کردن درها را به اشتراک گذاشتند. آنها موفق شدند با تغییر تدریجی مکان درها به روباتها بیاموزند که به آهستگی وظیفه خود را بهینه کنند. این کار باعث شد تا بعد از گذشت چند ساعت؛ این روباتها انعطافپذیری قابل قبولی داشته باشند.